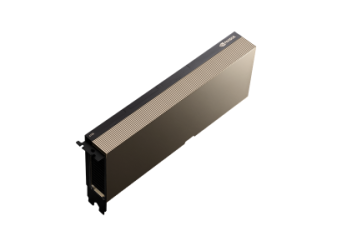

NVIDIA A100 80GB

- Architektura GPU NVIDIA Ampere

- Procesor graficzny zoptymalizowany pod obliczenia

- 6912 rdzeni NVIDIA CUDA

- 432 rdzenie NVIDIA Tensor

- 80 GB pamięci HBM2e z ECC

- Przepustowość pamięci do 1,935 GB/s

- Maksymalne zużycie energii: 300 W

- Magistrala graficzna: PCI-E 4.0 x16

- Chłodzenie: pasywne

Darmowa dostawa

Promocja cenowa na model HDR-15-5

Produkt przeznaczony wyłącznie do zastosowań profesjonalnych

NVIDIA A100 80GB

Opis

Procesor graficzny NVIDIA A100 Tensor Core GPU zapewnia bezprecedensowe przyspieszenie w każdej skali, zasilając najwydajniejsze elastyczne centra danych na świecie — przeznaczone do zastosowań w sztucznej inteligencji, analizie danych i obliczeniach wysokiej wydajności (HPC). Oparty na architekturze NVIDIA Ampere, układ A100 stanowi rdzeń platformy centrów danych NVIDIA. Oferuje do 20 razy wyższą wydajność w porównaniu z poprzednią generacją i może być podzielony na siedem niezależnych instancji GPU, aby dynamicznie dostosowywać się do zmieniających się potrzeb. Model A100 80GB wprowadza najszybszą przepustowość pamięci na świecie, przekraczającą 2 terabajty na sekundę (TB/s), co umożliwia obsługę największych modeli i zbiorów danych.

Specyfikacja

| A100 80GB PCIe | A100 80GB SXM | |

|---|---|---|

| FP64 | 9,7 TFLOPS | 9,7 TFLOPS |

| Rdzenie Tensor FP64 | 19,5 TFLOPS | 19,5 TFLOPS |

| FP32 | 19,5 TFLOPS | 19,5 TFLOPS |

| Tensor Float 32 (TF32) | 156 TFLOPS | 312 TFLOPS* | 156 TFLOPS | 312 TFLOPS* |

| Rdzenie Tensor BFLOAT16 | 312 TFLOPS | 624 TFLOPS* | 312 TFLOPS | 624 TFLOPS* |

| Rdzenie Tensor FP16 | 312 TFLOPS | 624 TFLOPS* | 312 TFLOPS | 624 TFLOPS* |

| Rdzenie Tensor INT8 | 624 TOPS | 1248 TOPS* | 624 TOPS | 1248 TOPS* |

| Pamięć GPU | 80 GB HBM2e | 80 GB HBM2e |

| Przepustowość pamięci GPU | 1 935 GB/s | 2 039 GB/s |

| Maksymalny pobór mocy (TDP) | 300 W | 400 W *** |

| Wieloinstancyjne GPU (MIG) | Do 7 MIG po 10 GB każdy | Do 7 MIG po 10 GB każdy |

| Format karty | PCIe — podwójny slot (chłodzenie powietrzem) lub pojedynczy slot (chłodzenie cieczą) | SXM |

| Interfejs połączenia | Mostek NVIDIA® NVLink® dla 2 GPU: 600 GB/s ** PCIe Gen4: 64 GB/s |

NVLink: 600 GB/s PCIe Gen4: 64 GB/s |

| Opcje serwerowe | Partnerzy i systemy certyfikowane przez NVIDIA z 1–8 GPU | NVIDIA HGX™ A100 — partnerzy i systemy certyfikowane przez NVIDIA z 4, 8 lub 16 GPU NVIDIA DGX™ A100 z 8 GPU |

| Uwagi | *Z użyciem sparsity **Wymaga mostka NVLink ***Konfigurowalne |

|